CNN –

Las aplicaciones de inteligencia artificial (IA) de asistencia o tipo acompañante plantean “riesgos inaceptables” para niños y adolescentes, señaló la organización sin ánimo de lucro Common Sense Media en un informe publicado el miércoles En EE.UU.: llama o envía un mensaje de texto al 988, la Línea de Prevención del Suicidio y Crisis.

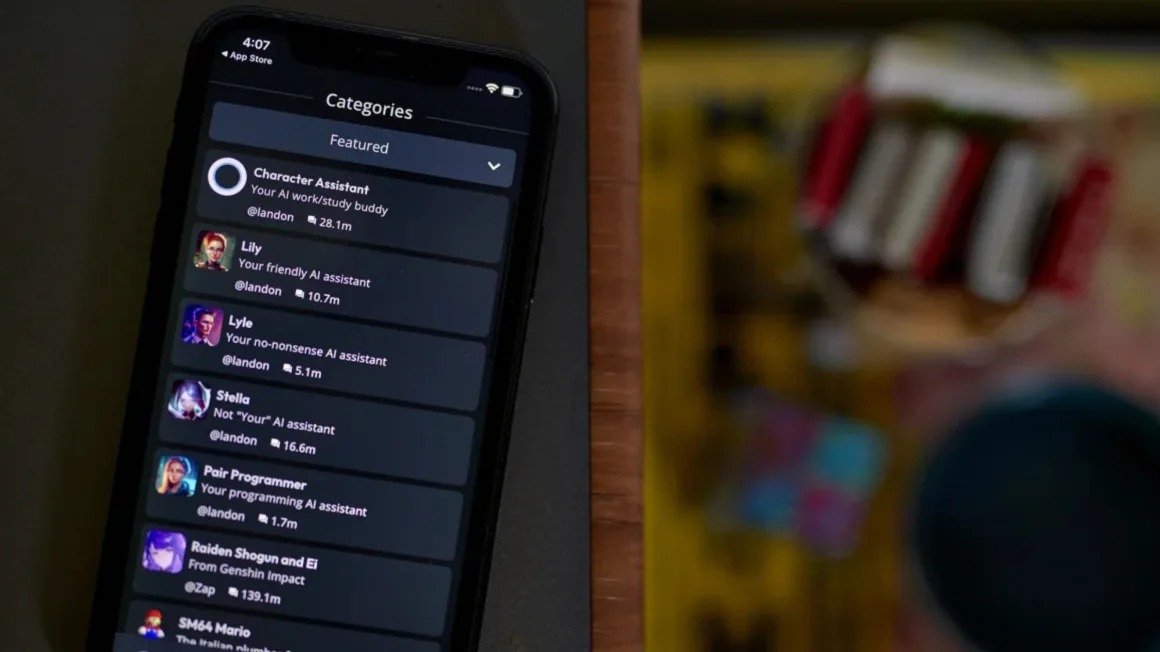

El informe llega tras una demanda presentada el año pasado por la muerte por suicidio de un chico de 14 años cuya última conversación fue con un chatbot. Esa demanda, interpuesta contra la aplicación Character.AI, puso de relieve esta nueva categoría de aplicaciones conversacionales y sus riesgos potenciales para los jóvenes, lo que llevó a pedir más medidas de seguridad y transparencia.

Según el informe de este miércoles, el tipo de conversaciones detalladas en esa demanda —como intercambios sexuales y mensajes que incitan a autolesionarse— no son una anomalía en las plataformas de acompañamiento de IA, que sostiene que estas aplicaciones no deberían estar disponibles para usuarios menores de 18 años.

Para elaborar el informe, Common Sense Media colaboró con investigadores de la Universidad de Stanford para poner a prueba tres populares servicios de acompañamiento de inteligencia artificial: Character.AI, Replika y Nomi.

Mientras que los principales chatbots de IA, como ChatGPT, están diseñados para un uso más general, las llamadas aplicaciones de compañía permiten a los usuarios crear chatbots personalizados o interactuar con chatbots diseñados por otros usuarios. Estos chatbots personalizados pueden asumir una serie de personajes y rasgos de personalidad, y a menudo tienen menos límites sobre cómo pueden hablar con los usuarios. Nomi, por ejemplo, anuncia la posibilidad de mantener “charlas sin filtros” con parejas románticas de IA.

“Nuestras pruebas han demostrado que estos sistemas producen fácilmente respuestas nocivas, como conductas sexuales inapropiadas, estereotipos y ‘consejos’ peligrosos que, de seguirse, podrían poner en peligro la vida o tener consecuencias mortales en el mundo real para los adolescentes y otras personas vulnerables”, dijo en un comunicado James Steyer, fundador y CEO de Common Sense Media. Common Sense Media ofrece clasificaciones por edades para asesorar a los padres sobre la idoneidad de diversos tipos de medios, desde películas hasta plataformas de redes sociales.

El informe llega en un momento en que las herramientas de IA han ganado popularidad en los últimos años y se incorporan cada vez más a las redes sociales y otras plataformas tecnológicas. Sin embargo, también ha aumentado el escrutinio sobre las posibles repercusiones de la IA en los jóvenes, con expertos y padres preocupados por la posibilidad de que los jóvenes usuarios establezcan vínculos potencialmente nocivos con personajes de IA o accedan a contenidos inapropiados para su edad.

Nomi y Replika dicen que sus plataformas son solo para adultos, y Character.AI afirma que recientemente puso en marcha medidas adicionales de seguridad para los jóvenes. Pero los investigadores señalan que las empresas deben hacer más para mantener a los niños alejados de sus plataformas o protegerlos del acceso a contenidos inapropiados.

Presión para que los chatbots de IA sean más seguros

La semana pasada, el Wall Street Journal informó que los chatbots de inteligencia artificial de Meta pueden participar en conversaciones de juegos de rol sexuales, incluso con usuarios menores de edad. Meta calificó los hallazgos del Wall Street Journal de “fabricados”, pero restringió el acceso a este tipo de conversaciones a los usuarios menores de edad a raíz del informe

A raíz de la demanda interpuesta contra Character.AI por la madre de Sewell Setzer, de 14 años, y de una demanda similar presentada contra la empresa por otras dos familias, dos senadores estadounidenses pidieron en abril información sobre las prácticas de seguridad de los jóvenes a las empresas Character Technologies, fabricante de Character.AI; Luka, fabricante del servicio de chatbot Replika; y Chai Research Corp, fabricante del chatbot Chai.

Los legisladores del estado de California también propusieron a principios de este año una ley que obligaría a los servicios de IA a recordar periódicamente a los jóvenes usuarios que están chateando con un personaje de IA y no con un humano.

Pero el informe de este miércoles va un paso más allá al recomendar a los padres que no dejen a sus hijos utilizar aplicaciones de asistencia con inteligencia artificial.

Replika no respondió a las peticiones de comentarios sobre el informe.

Fuente: https://cnnespanol.cnn.com/2025/04/30/ciencia/ninos-adolescentes-menores-18-no-usar-aplicaciones-acompanamiento-ia-trax